01 멘토 소개

MS Course

백창우

CVSP(Computer Vision&Signal Processing Lab.)

•

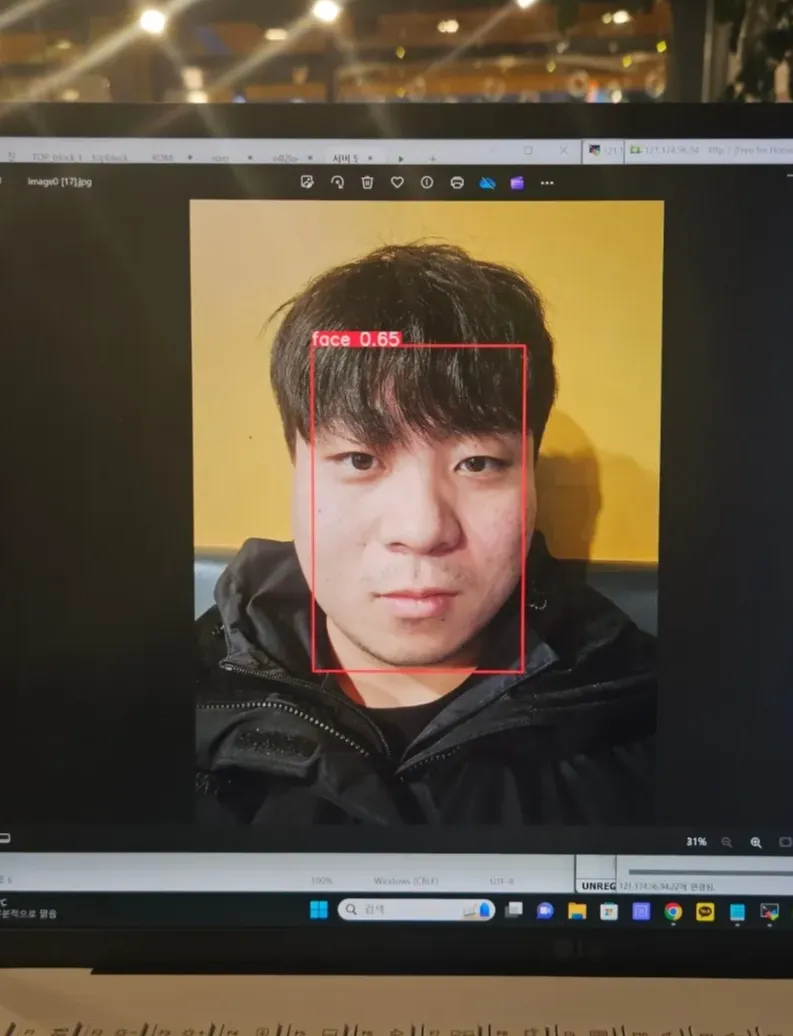

관심 분야 | Generative AI, Multi-Modal, Person Re-Identification, Face Recognition

higok18@pusan.ac.kr

MS Course

정다운

CVSP(Computer Vision&Signal Processing Lab.)

•

관심 분야 | Generative AI, Person Re-Identification, Human-Pose Estimation

undajeong@pusan.ac.kr

02 프로젝트 소개

2.1. Intro

[좌: LG전자 홈로봇 Q9 우: 삼성전자 홈로봇 볼리]

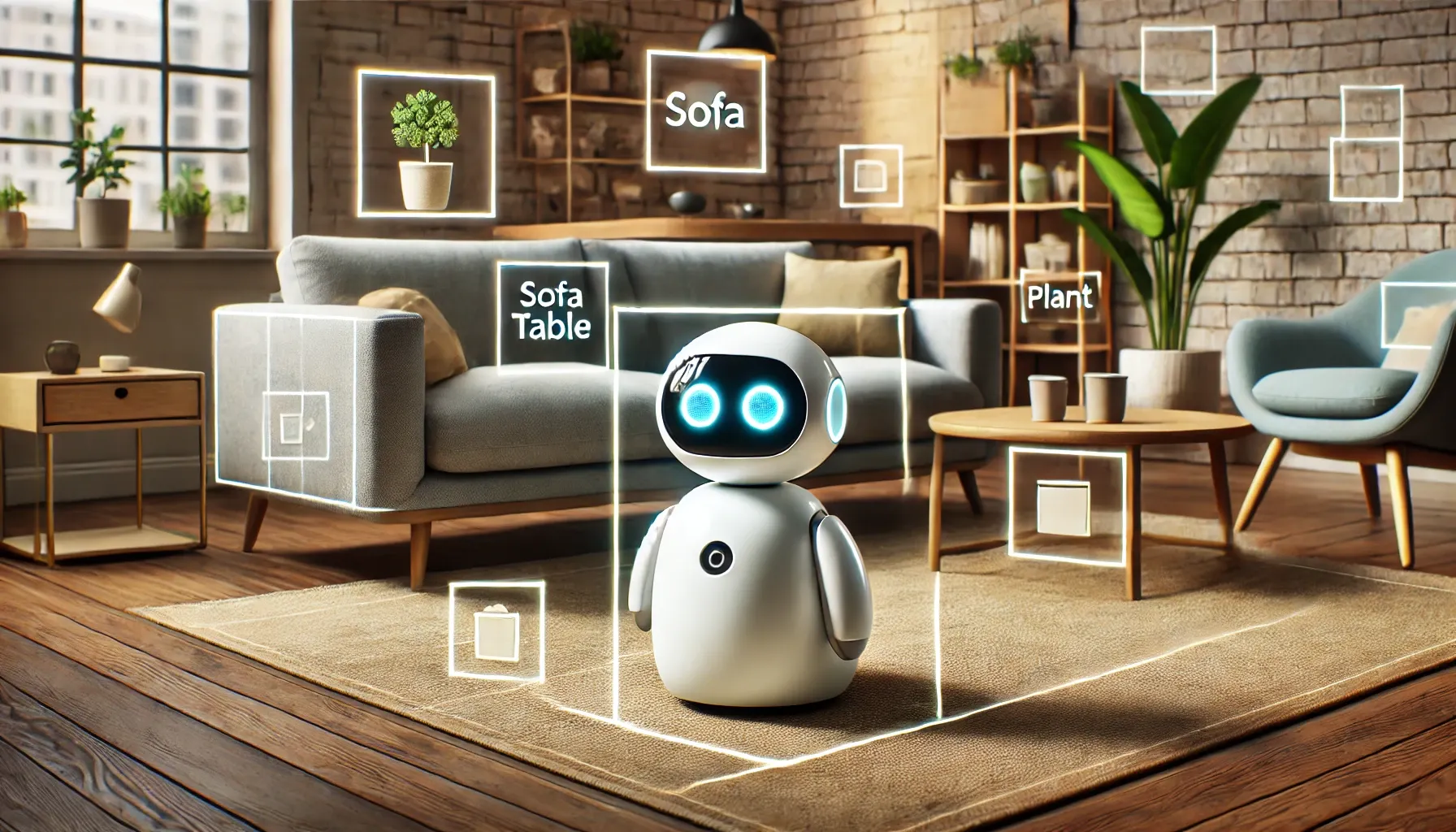

2024년 CES와 IFA에서 여러 글로벌 기업들이 앞다투어 홈 로봇 기술을 선보이며 뜨거운 관심을 받고 있습니다

홈 로봇은 가정 내 다양한 작업을 수행하기 위해 설계되지만 새로운 물체나 상황을 빠르게 인식하고 대응하기 위해서는 대규모 라벨링 데이터에 대한 의존도가 높아지는 한계가 있습니다. 이는 사전에 모든 환경과 물체를 학습시키는 것이 비효율적이고 새로운 상황에 일반화하는 능력이 부족하기 때문입니다.

예를 들어 사용자가 '테이블 위에 놓인 파란 물병을 찾아줘'라고 명령했을 때 로봇은 테이블과 물병을 탐지하고, 물병의 속성인 '파란색'과 위치 관계인 '테이블 위에 있다'를 추론해야 합니다. 기존의 물체 탐지 모델은 테이블과 물병을 개별적으로 탐지하는 데는 유리하지만 '파란색'과 같은 속성을 이해하거나 공간적 관계를 명시적으로 연결하는 데는 한계가 있습니다.

CLIP 모델은 이미지와 텍스트를 연결하는 강력한 학습 능력을 바탕으로 Zero-Shot Classification이 가능하며 사전 학습된 데이터 외의 새로운 환경에서도 유연하게 활용될 수 있습니다.

그러나 홈 로봇은 실시간 처리가 필수적이며, 이는 계산 효율성과 모델의 경량화가 요구되는 도전 과제입니다.

이번 프로젝트에서는 CLIP 모델을 홈 로봇 환경에 맞게 전이 학습(Transfer Learning)하고, Knowledge Distillation을 통해 모델을 경량화하여 실시간 Zero-Shot Object Detection 성능을 강화한 시스템을 제안합니다. 이를 통해 홈 로봇이 다양한 물체와 명령을 빠르게 탐지하고, 사용자와의 상호작용을 더욱 자연스럽고 효율적으로 지원할 수 있을 것입니다.

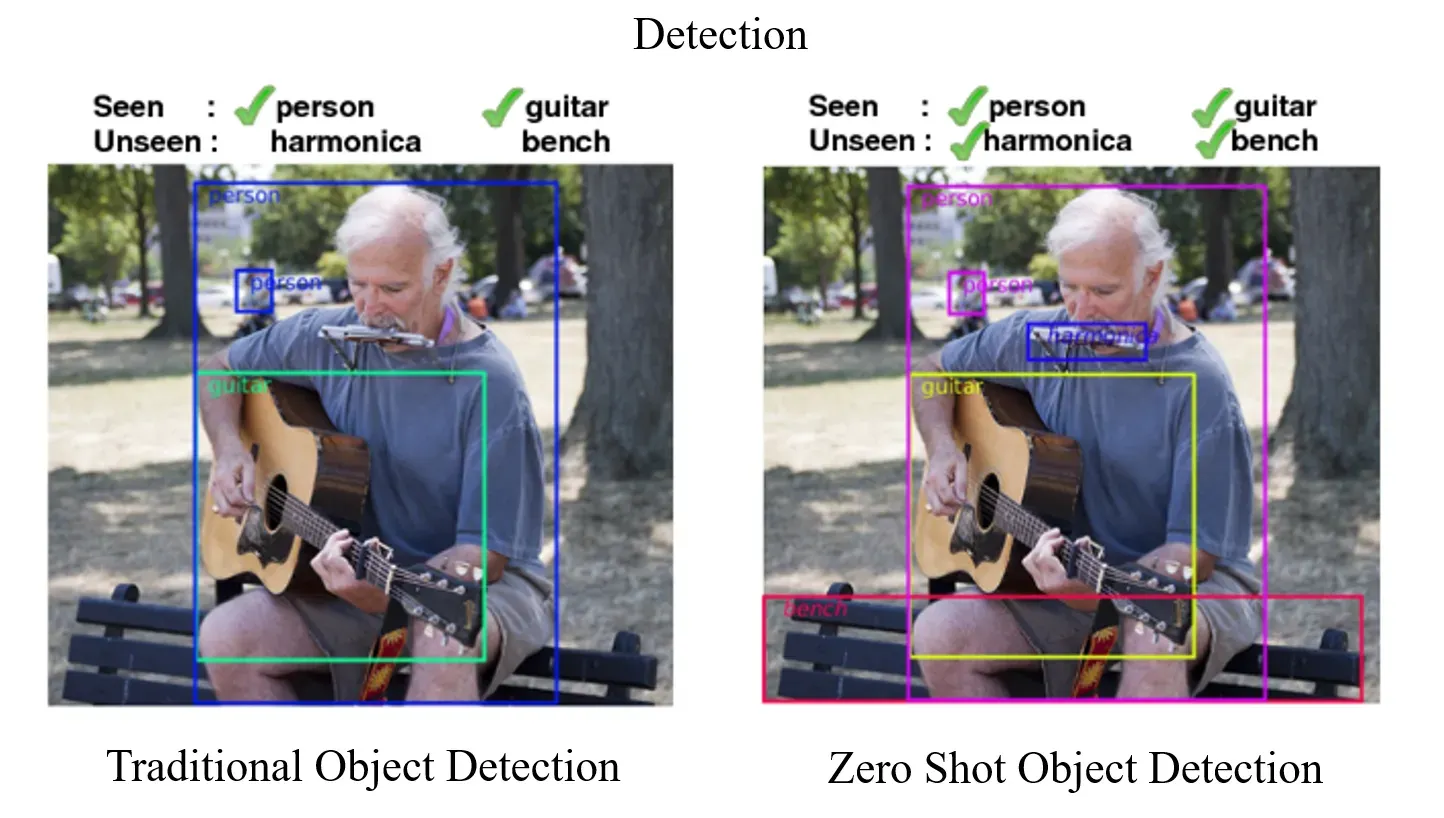

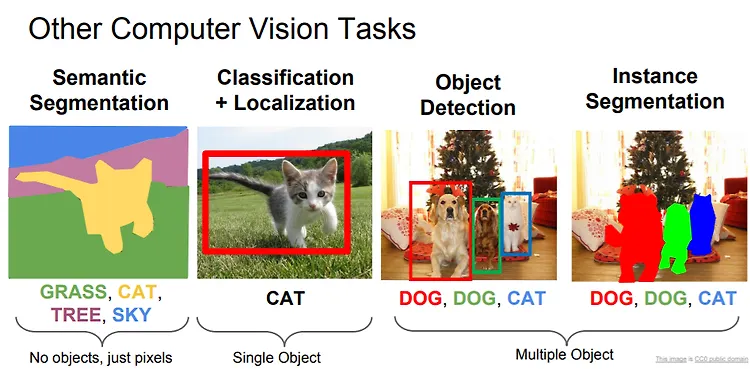

2.2. Zero-Shot Object Detection

Zero-Shot Object Detection (ZSD)은 라벨링된 데이터가 없는 새로운 객체를 탐지하는 기술로 CLIP의 이미지-텍스트 매핑 능력을 활용하여 학습되지 않은 클래스도 탐지할 수 있습니다. 기존의 Object Detection 모델은 고정된 클래스 라벨에 의존하지만 ZSD는 텍스트 설명(예: "파란 물병")을 기반으로 물체를 탐지합니다.

대표적으로 RegionCLIP, Detic, Grounding DINO와 같은 모델들이 사용되며 이들 모두 CLIP의 Zero-Shot 학습 능력을 활용하여 새로운 객체와 텍스트 간의 관계를 탐지합니다. 이번 프로젝트에서도 CLIP 기반 Detection 모델을 활용하여 홈 로봇 환경에 적합한 Zero-Shot Object Detection 시스템을 구현할 예정입니다

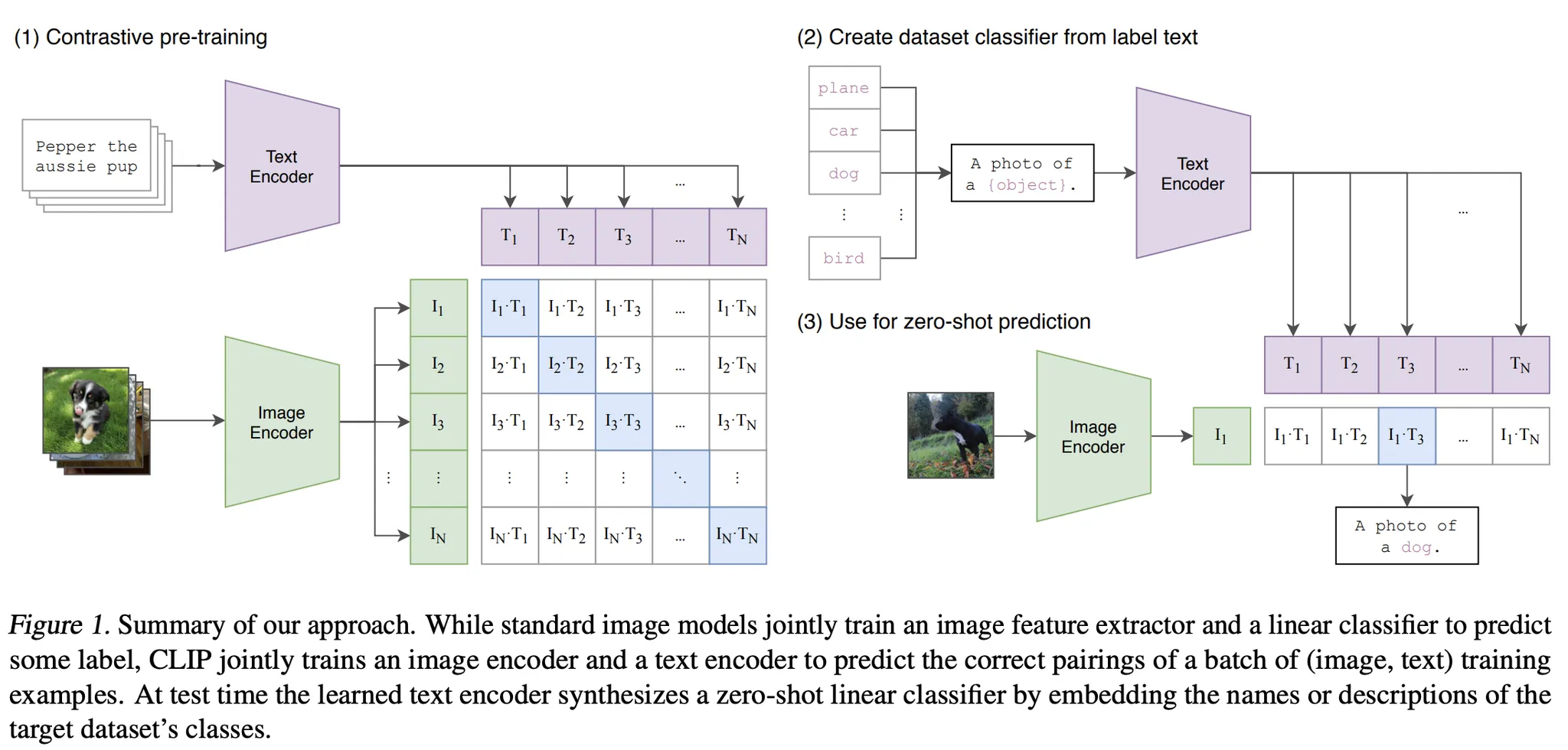

2.3. CLIP

CLIP은 이미지와 텍스트를 동시에 학습하는 OpenAI의 사전 학습(Pre-trained) 모델로, 두 데이터를 연결하는 강력한 성능을 제공합니다.

대규모 이미지-텍스트 쌍 데이터를 활용해 사전 학습된 CLIP은 대조 학습(Contrastive Learning)을 통해 이미지와 텍스트를 동일한 벡터 공간에 매핑하며 Zero-Shot Classification, 이미지 검색, 텍스트 기반 분류 등 다양한 작업을 수행할 수 있습니다.

구성 요소

•

이미지 인코더

ResNet 또는 Vision Transformer를 사용해 이미지를 고차원 벡터로 변환하는 인코더 입니다

•

텍스트 인코더

Transformer 기반으로 텍스트를 임베딩 벡터로 변환하는 인코더 입니다

CLIP Model의 한계

CLIP은 일반적인 데이터에 대해 사전 학습되었기 때문에 홈 로봇 환경과 같은 특수한 데이터에서는 성능이 제한적일 수 있습니다.  홈 로봇은 다양한 물체와 새로운 상황을 실시간으로 처리해야 하는데 이러한 환경은 CLIP의 사전 학습 데이터와 다를 가능성이 높습니다. 이를 해결하기 위해 로봇 환경에 맞는 데이터를 활용한 추가적인 학습이 필요합니다

홈 로봇은 다양한 물체와 새로운 상황을 실시간으로 처리해야 하는데 이러한 환경은 CLIP의 사전 학습 데이터와 다를 가능성이 높습니다. 이를 해결하기 위해 로봇 환경에 맞는 데이터를 활용한 추가적인 학습이 필요합니다

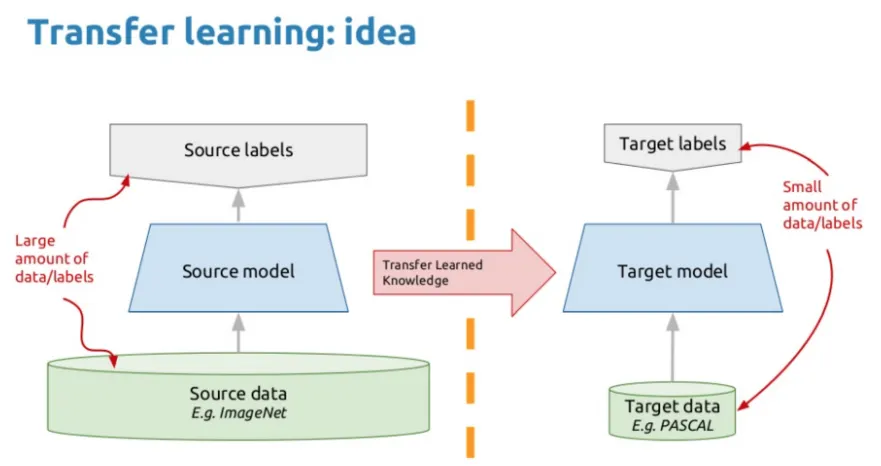

2.4. Transfer Learning

Transfer Learning은 사전 학습된 모델을 새로운 데이터나 작업에 맞게 재활용하는 학습 방법으로, 적은 데이터와 자원으로도 높은 성능을 낼 수 있는 강력한 기법입니다. 이번 프로젝트에서는 CLIP 모델이 학습한 이미지-텍스트 관계를 로봇 도메인에 적합하도록 Fine-Tuning을 적용할 예정입니다.

CLIP은 대규모 이미지-텍스트 쌍 데이터를 기반으로 학습되어 Zero-Shot Object Detection과 같은 일반적인 작업에 뛰어난 성능을 보입니다. 그러나 로봇 도메인과 같은 특수한 환경에서는 성능이 제한적일 수 있습니다. 이를 해결하기 위해 시각적 데이터, 특히 로봇 환경의 데이터를 활용하여 CLIP 모델의 가중치를 미세 조정(Fine-Tuning)하여 로봇 도메인에 특화된 Object Detection 모델을 구현하고자 합니다.

Transfer Learning은 기존의 사전 학습된 지식을 유지하면서 새로운 데이터에 적응할 수 있어 효율적이고 효과적인 학습을 가능하게 합니다. 이 접근법을 통해 새로운 장애물 또는 사물에 대해 빠르고 유연한 객체 탐지가 가능해지며 추가적인 라벨링 없이도 도메인 맞춤형 솔루션을 제공할 수 있을 것으로 기대됩니다.

03 일정 소개

3.1. AI 기초

AI, Deep Learning에 대해 잘 알고 있는 사람도 있겠지만, 처음 접하는 사람도 있을 것입니다. 이번 겨울방학에는 AI 기초부터 시작해 모든 학우가 함께 배울 수 있는 시간을 가질 예정입니다.

기초 이론을 탄탄히 다지는 것부터 시작해 MLP, CNN, Transformer 구조와 여러 비전 Task, Multi-modal 관련 내용을 배우며 이를 코딩 실습과 연계하여 학습합니다. 차근차근 진행하여 실제 프로젝트를 해결할 수 있는 능력을 배양하는 것을 목표로 합니다

3.2. 모델 선정

CLIP 모델의 성능은 이미지 인코더와 텍스트 인코더의 구조에 따라 달라지며 이는 Zero-Shot Object Detection에서 정확도와 처리 속도 간의 Trade-Off를 형성합니다. ResNet 기반의 이미지 인코더는 경량화되어 빠른 처리 속도를 제공하지만 복잡한 물체나 관계를 표현하는 데 한계가 있을 수 있습니다. 반면 Vision Transformer(ViT) 기반 인코더는 더 높은 표현력을 가지지만 연산 비용이 증가해 실시간 처리 요구를 충족하기 어려울 수 있습니다.

홈 로봇은 실시간으로 물체를 탐지하고 사용자 명령에 반응해야 하므로 정확도와 실시간성의 균형을 맞춘 최적의 모델을 선정하는 것을 목표로 합니다.

3.3. 데이터 수집 및 필터링

Detection 모델의 성능은 대부분은 데이터가 결정한다 해도 과언이 아닙니다. 실제 AI 엔지니어분들도 데이터 수집 및 필터링 시간에 많은 시간을 소요합니다.

홈 로봇 도메인에 적합한 데이터를 선정하고 여러 검색 엔진에서 Open 데이터를 수집하여 필터링 후 이를 결합하여 학습을 할 예정입니다.

3.4. Transfer Learning 최적화

Pre-trained Zero-Shot Detection(ZSD) 모델을 수집한 데이터로 Transfer Learning을 적용하여, 홈 로봇 도메인에서 물체 탐지 성능을 최적화하는 것을 목표로 합니다. 모델의 어느 레이어를 학습할지 신중히 선택하여, 도메인 적응 성능과 기존 Zero-Shot 능력 간의 균형을 유지할 계획입니다.

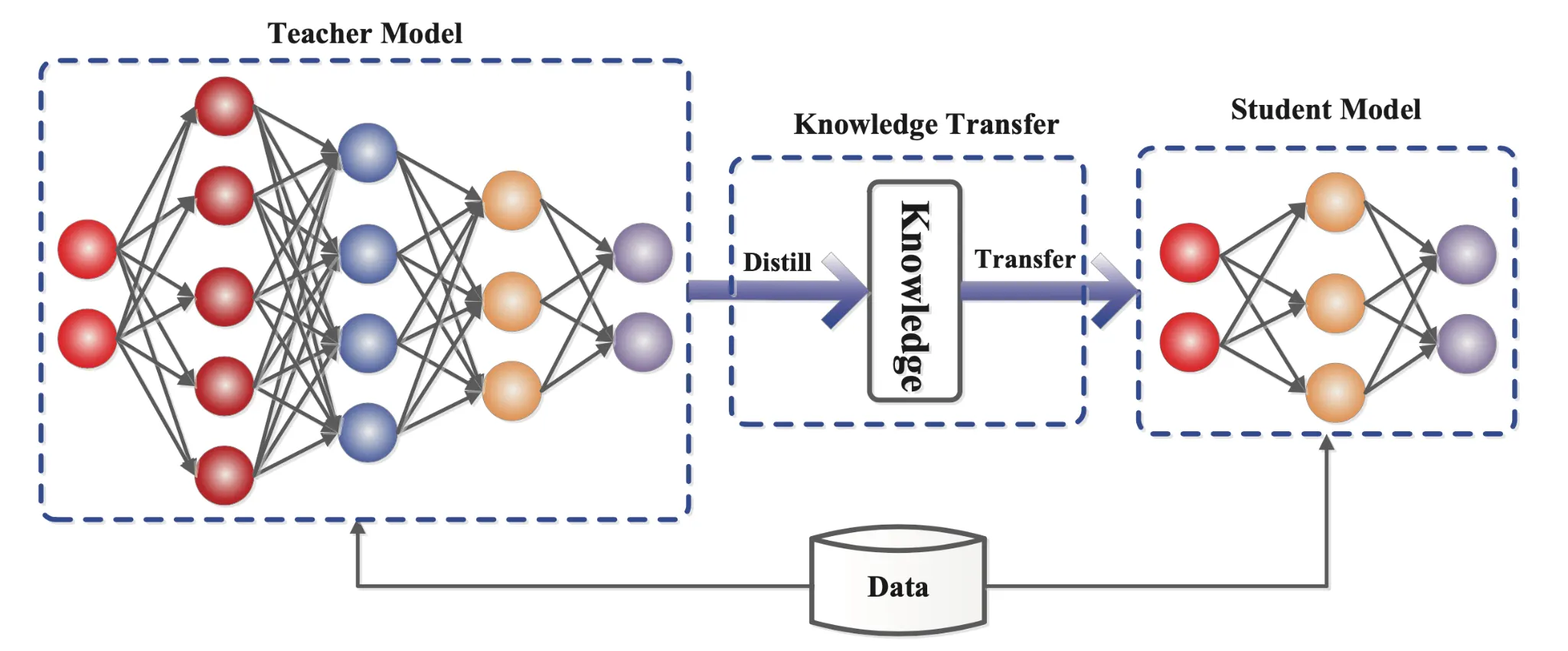

3.5. Knowledge Distillation

Knowledge Distillation은 고성능 모델(Teacher Model)에서 학습한 지식을 경량화된 모델(Student)에 전이하여 연산 효율성을 향상시키면서도 성능 저하를 최소화하는 기술입니다. 홈 로봇의 Zero-Shot Object Detection 시스템에서 실시간 탐지와 정확성 유지를 동시에 달성하기 위해 Knowledge Distillation를 활용할 계획입니다.

3.6. 관련 최신 논문 기술 적용

Transfer Learning, Zero-Shot Classification, 그리고 홈로봇 분야와 관련된 최신 논문들의 기술을 검토하여 이를 프로젝트에 적용해보는 것을 목표로 합니다. 최신 연구에서 제시된 아이디어를 활용함으로써 모델의 성능을 향상시키고 새로운 접근 방식을 실험할 계획입니다.

또한 프로젝트를 진행하며 좋은 아이디어가 도출된다면 이를 발전시켜 연구 논문 작성까지 이어지는 것을 목표로 삼을 수 있습니다

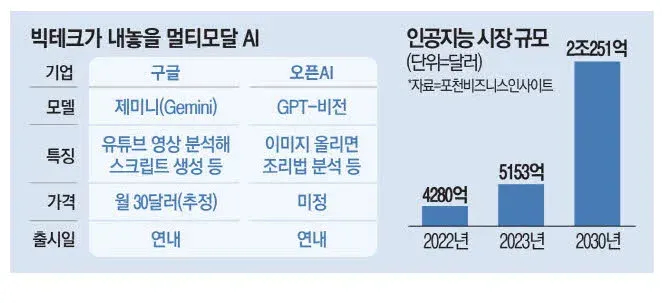

04 다양한 애플리케이션

홈 로봇에서의 Zero- Shot Detection을 목표로 이번 프로젝트를 하지만 앞서 설명드린 Multi-Modal model인 CLIP, On-device AI를 위한 경량화 기술은 다양한 분야의 Task로의 확장이 무궁무진합니다.

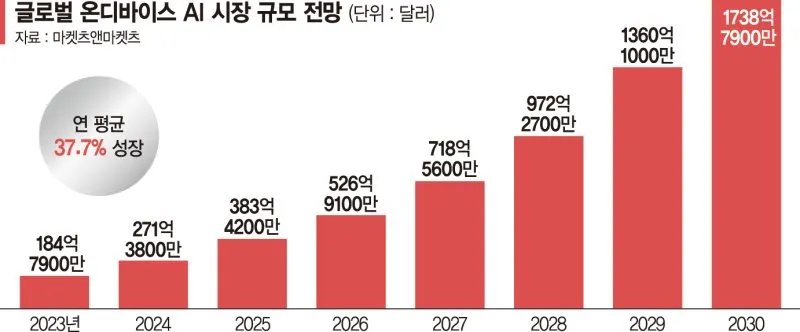

매년 Multi-Modal 및 On-Device 시장이 나날이 커지고 있고 Open AI, 애플, 삼성전자, LG전자 등 다양한 글로벌 기업들이 앞다투어 경쟁하고 있습니다. 이번 프로젝트를 통해 트렌디한 기술들을 다뤄보며

AI를 처음 접하는 친구도 이미 관심이 많은 친구도 함께 배우고 성장할 수 있는 의미 있는 경험이 되었으면 좋겠습니다

Objective

•

모델 성능 테스트 결과를 정리하여 대한전자공학회 추계학술대회 등 국내학회 논문 제출

이런 Fellow를 찾아요!

•

문제 해결 능력이 뛰어난 사람

•

끈기와 열정이 있는 사람

•

프로젝트를 발전시켜 국내 학회에 논문을 제출해보고 싶으신 분

Contact

•

이 프로젝트에 관해 궁금하신 게 있는 분은 이메일로 문의 부탁드려요